小黑盒的家人們,今天來給大夥分享一個超酷的裝機和模型部署經歷!最近在 AI 熱潮的影響下,我也想自己搭建一個本地的大模型環境,正好 Ultra 系列 CPU 大降價,我就入手了一顆 Ultra 245K,打算用它來本地化部署 DeepSeek 模型,順便給自己打造一臺能跑 AI 的工作站。下面就詳細給大家講講整個過程,包括裝機方案、性能測試、軟件安裝、模型部署,還有遇到的那些坑和解決辦法。

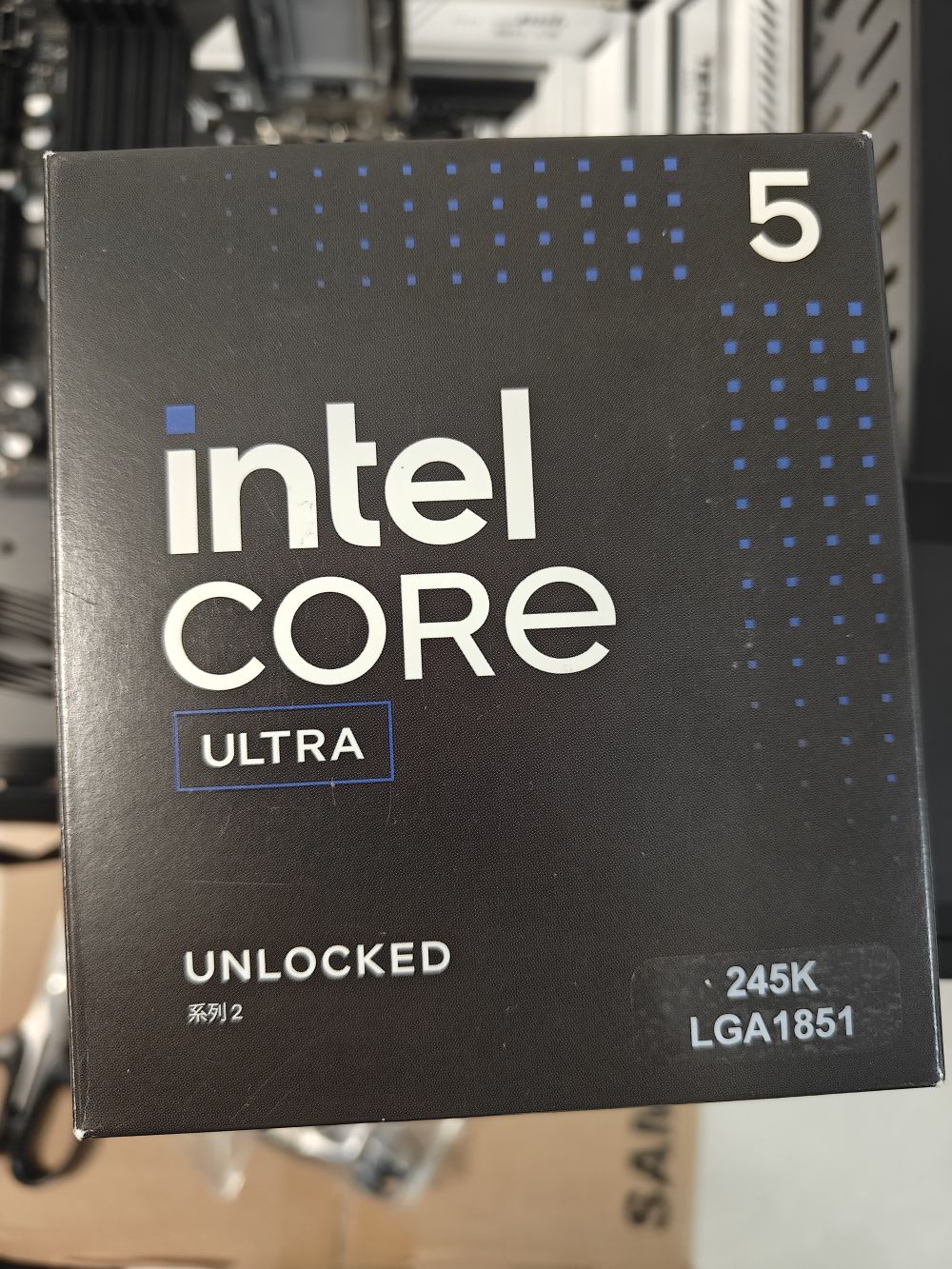

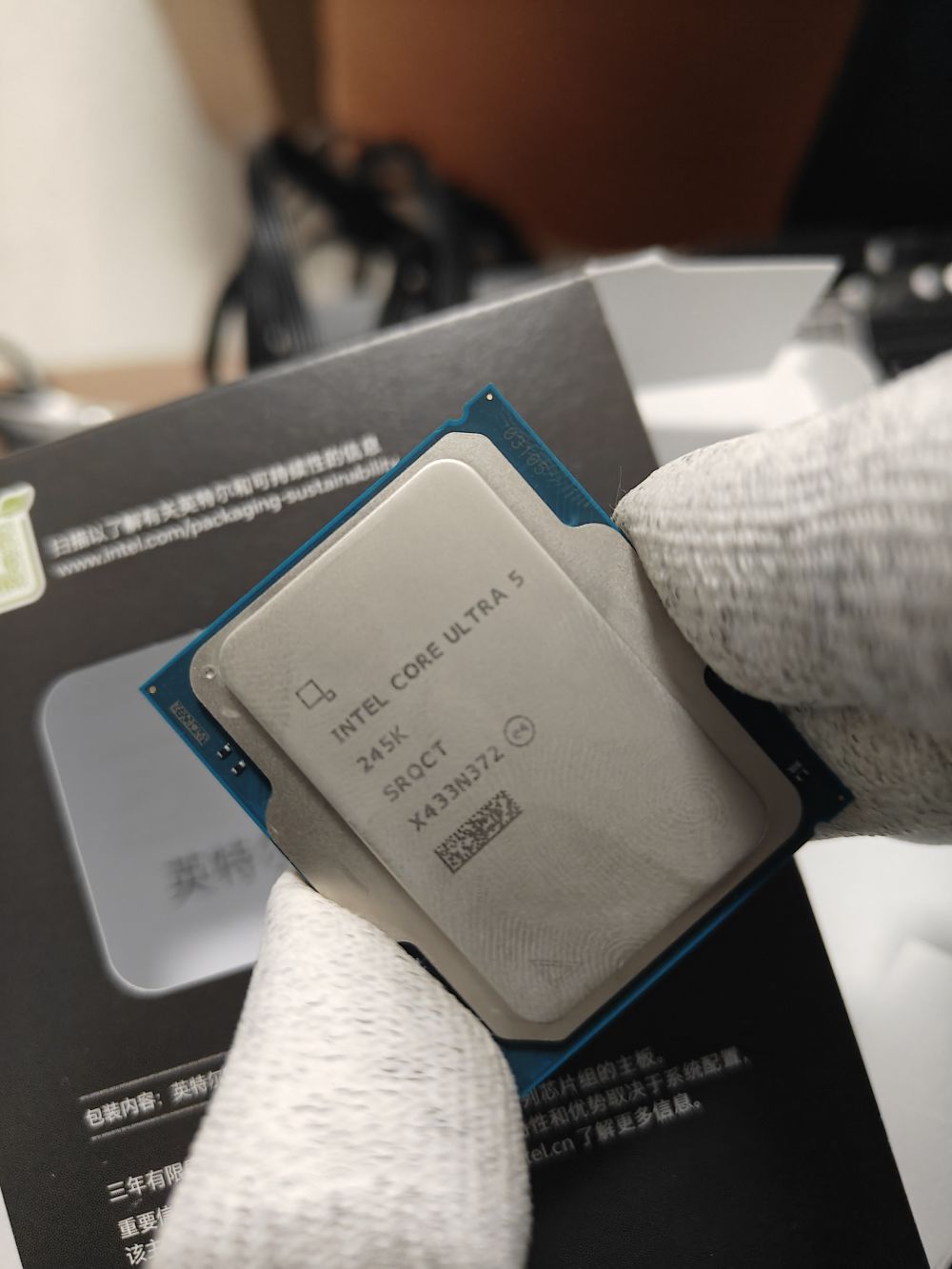

先來說說裝機方案。CPU 選的是 Intel ultra 245K,它的包裝很有特色,小黑盒正面有個透明觀察窗,能直接看到 CPU,設計感拉滿。打開包裝,CPU 正面刻著型號、序列號這些重要信息,還有個二維碼,背面的觸電和電容排布得特別規整,而且裝機時通過偏心的兩個凹槽就能輕鬆確定安裝方向,很貼心。

主板我用的是銘宣終結者 B860M,黑白色調,12 相供電,能穩穩地支持 UltraCPU。它支持雙通道 4 根 DDR5 內存,最大能到 128GB,還原生支持 7000Mhz DDR5 內存頻率,高負載場景下相比 DDR4 有明顯的速度提升。內存我挑的是光威龍武 DDR5 16*2 6000mhz 套條,活動價 400 多就能拿下,性價比超高。機箱用的拓撲龍開放式機箱,只要 30 塊,比鞋盒強多了。電源選的愛國者 EP650 650w 全模組電源,200 塊左右,用起來很穩定。

裝機完成後,得測試下 CPU 性能。我用 3DMark CPU Profile 測試,它能顯示 CPU 在不同核心和線程數下的表現。結果 Ultra245K 單線程分數 1213 分,處理單核心任務很出色;最大線程得分 12348 分,多任務並行處理能力也超棒。在 CPU-Z 測試中,單核心 800 分,多核心 10051 分,多核心成績幾乎和曾經的頂級處理器 12900K 持平,日常使用和複雜專業應用都能輕鬆應對。

再看看核顯。14 代 CPU 的 HD770 核顯大家可能比較熟悉,Ultra245K 升級到了 4Xe-core 的新式核顯,性能突破明顯。它有 4 個 1.9GHz 的 Xecore,最大支持 8K 60hz 編解碼,AI 算力在 int8 精度下達到 8TOPS,是 HD770 核顯的 2.6 倍。而且支持英特爾 DLBoost 深度學習加速技術,int4 量化部署時算力為 16TOPS,達到了大模型端側部署的算力門檻,對本地化 AI 推理幫助很大。

接下來就是安裝依賴軟件。先去英特爾官網下載最新的 GPU 驅動,官網鏈接在文檔裡都有,按照系統版本下載就行。然後下載 ipex-llm ollama 部署包,這是 intel 官方的開源大模型項目,能在 intelgpu 上進行高性能大模型推理和訓練微調。從官網下載對應版本解壓就好。

軟件安裝好後,就可以進行 Ollama 啟動和模型部署了。在解壓後的文件夾裡按住 Shift + 右鍵,選擇在終端中打開,輸入./start-ollama.bat 啟動 Ollama,會彈出一個有很多日誌的命令行窗口,別關閉它。接著在這個命令行窗口輸入.\ollama.exe pull deepseek-r1:7b 來下載 DeepSeek 模型,耐心等待模型加載完成就行。

模型下載好後,Ollama 在後臺就緒,不過命令行對話不太方便,我用了 AnythingLLM 這個軟件。去官網下載安裝,安裝好啟動後,在模型選擇位置選 ollama,就能看到我們下載的 DeepSeekR1 模型了。創建個工作區,隨便取個名,我取名為 DeepSeek-iGPU,選中工作區再選 NewThread 開啟新對話,就能和 DeepSeekR1 愉快聊天啦。我讓它介紹 Ultra 系列處理器,它不僅回答得條理清晰,思考鏈也正常工作,而且模型的 token 生成速率大約為 10token/s,個人使用對話很流暢。從任務管理器能看到,核顯基本滿載,用了 7.2G 主機內存。

最後說說 NPU。Ultra 245K 的 NPU 是個大亮點,雖然我一開始想用它部署模型,但因為 NPU 太新,遇到了不少 bug。不過我已經把這些 Bug 提交到 Intel ipex-llm 了,按照他們的更新速度,下個月左右應該就能用 NPU 進行模型推理和部署,到時候核顯壓力會更小,還能構建更高性能的 AI 工作站。

這次用 Ultra245K 搭建 DeepSeek 本地模型,整體體驗還是很不錯的。雖然過程中遇到了一些小波折,但最後成功跑起來模型,還能流暢對話,成就感滿滿。如果大家也對本地化部署大模型感興趣,不妨參考我的經驗試試,有問題咱們評論區交流!