小黑盒的家人们,今天来给大伙分享一个超酷的装机和模型部署经历!最近在 AI 热潮的影响下,我也想自己搭建一个本地的大模型环境,正好 Ultra 系列 CPU 大降价,我就入手了一颗 Ultra 245K,打算用它来本地化部署 DeepSeek 模型,顺便给自己打造一台能跑 AI 的工作站。下面就详细给大家讲讲整个过程,包括装机方案、性能测试、软件安装、模型部署,还有遇到的那些坑和解决办法。

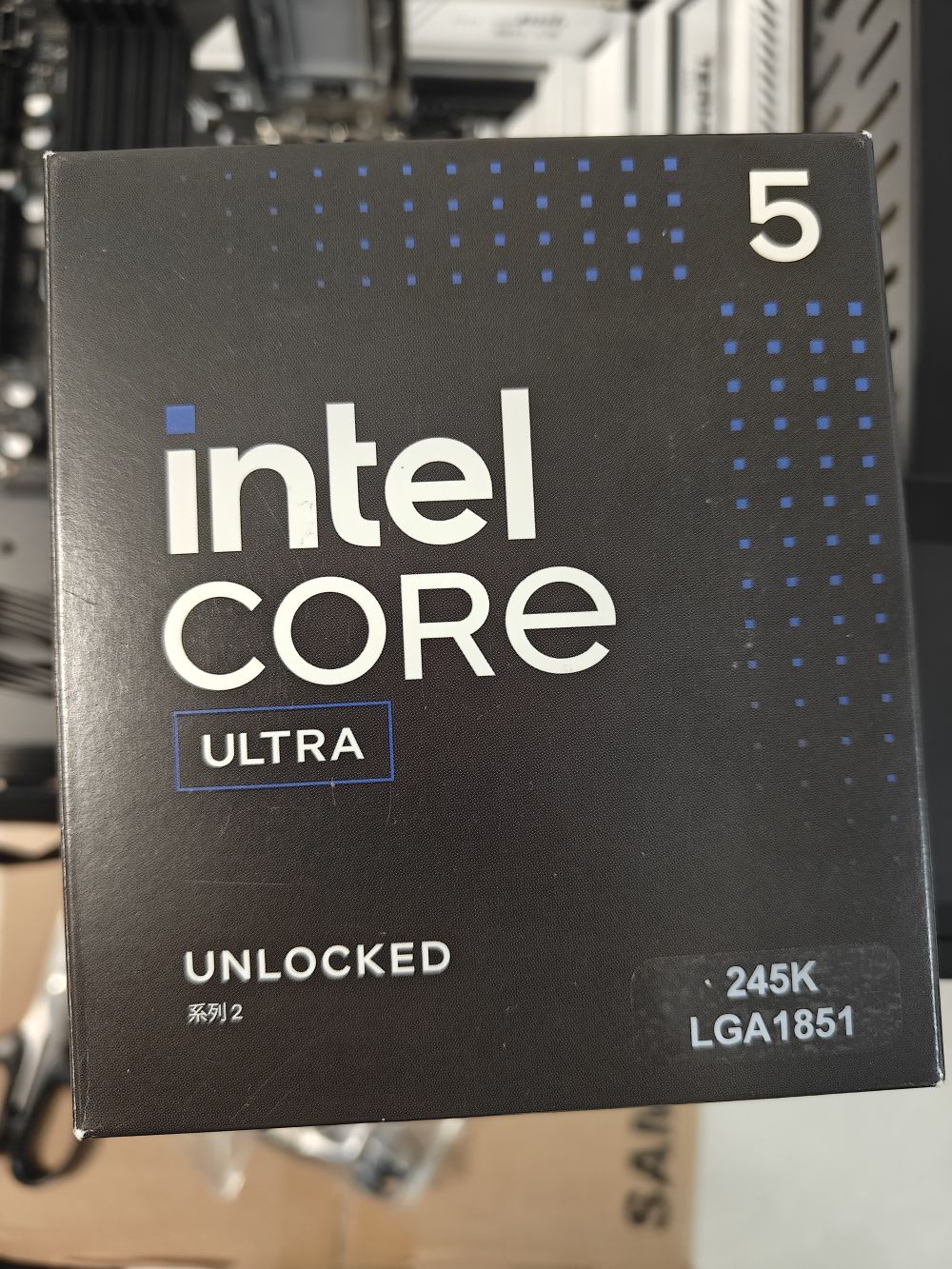

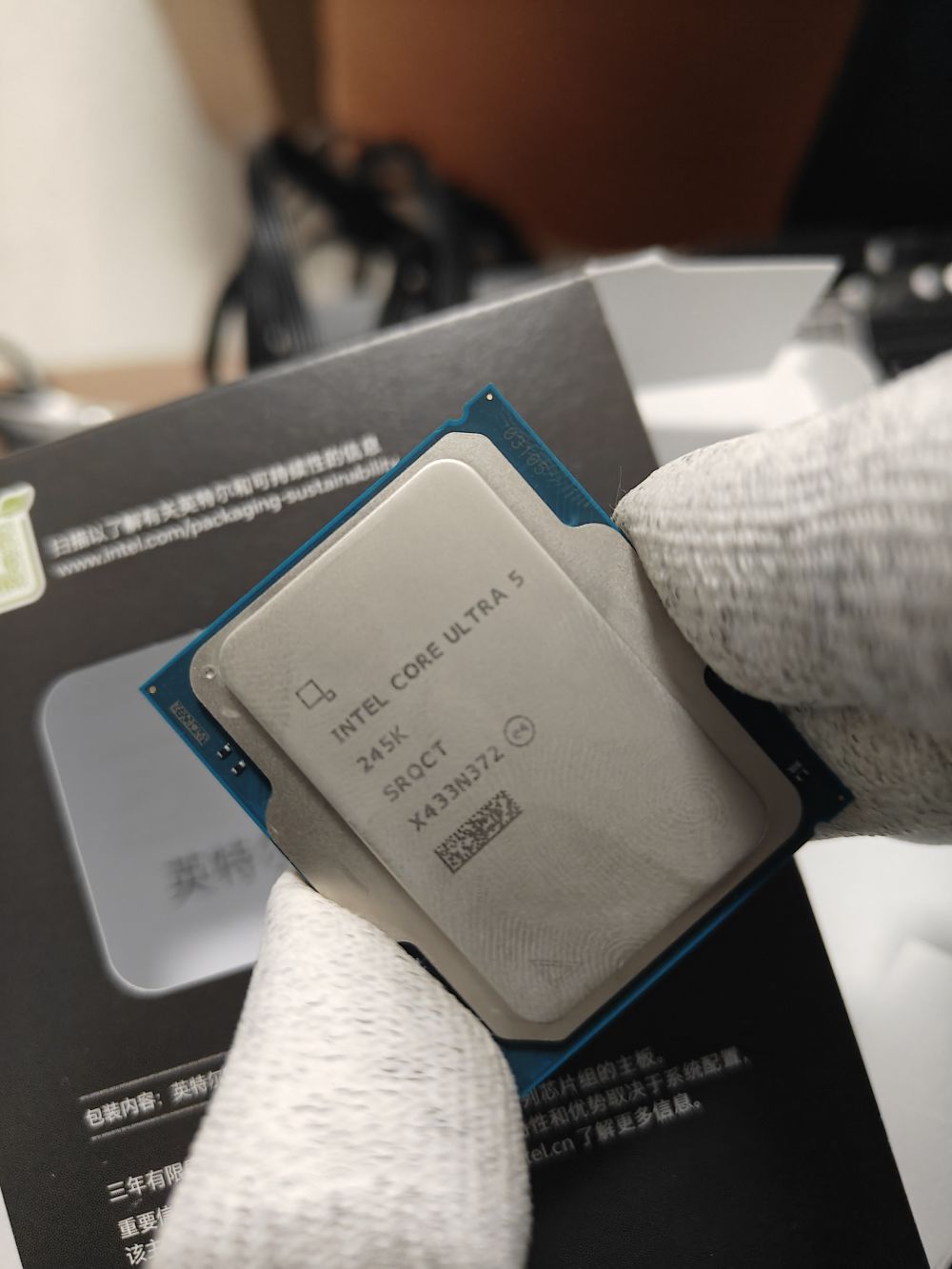

先来说说装机方案。CPU 选的是 Intel ultra 245K,它的包装很有特色,小黑盒正面有个透明观察窗,能直接看到 CPU,设计感拉满。打开包装,CPU 正面刻着型号、序列号这些重要信息,还有个二维码,背面的触电和电容排布得特别规整,而且装机时通过偏心的两个凹槽就能轻松确定安装方向,很贴心。

主板我用的是铭宣终结者 B860M,黑白色调,12 相供电,能稳稳地支持 UltraCPU。它支持双通道 4 根 DDR5 内存,最大能到 128GB,还原生支持 7000Mhz DDR5 内存频率,高负载场景下相比 DDR4 有明显的速度提升。内存我挑的是光威龙武 DDR5 16*2 6000mhz 套条,活动价 400 多就能拿下,性价比超高。机箱用的拓扑龙开放式机箱,只要 30 块,比鞋盒强多了。电源选的爱国者 EP650 650w 全模组电源,200 块左右,用起来很稳定。

装机完成后,得测试下 CPU 性能。我用 3DMark CPU Profile 测试,它能显示 CPU 在不同核心和线程数下的表现。结果 Ultra245K 单线程分数 1213 分,处理单核心任务很出色;最大线程得分 12348 分,多任务并行处理能力也超棒。在 CPU-Z 测试中,单核心 800 分,多核心 10051 分,多核心成绩几乎和曾经的顶级处理器 12900K 持平,日常使用和复杂专业应用都能轻松应对。

再看看核显。14 代 CPU 的 HD770 核显大家可能比较熟悉,Ultra245K 升级到了 4Xe-core 的新式核显,性能突破明显。它有 4 个 1.9GHz 的 Xecore,最大支持 8K 60hz 编解码,AI 算力在 int8 精度下达到 8TOPS,是 HD770 核显的 2.6 倍。而且支持英特尔 DLBoost 深度学习加速技术,int4 量化部署时算力为 16TOPS,达到了大模型端侧部署的算力门槛,对本地化 AI 推理帮助很大。

接下来就是安装依赖软件。先去英特尔官网下载最新的 GPU 驱动,官网链接在文档里都有,按照系统版本下载就行。然后下载 ipex-llm ollama 部署包,这是 intel 官方的开源大模型项目,能在 intelgpu 上进行高性能大模型推理和训练微调。从官网下载对应版本解压就好。

软件安装好后,就可以进行 Ollama 启动和模型部署了。在解压后的文件夹里按住 Shift + 右键,选择在终端中打开,输入./start-ollama.bat 启动 Ollama,会弹出一个有很多日志的命令行窗口,别关闭它。接着在这个命令行窗口输入.\ollama.exe pull deepseek-r1:7b 来下载 DeepSeek 模型,耐心等待模型加载完成就行。

模型下载好后,Ollama 在后台就绪,不过命令行对话不太方便,我用了 AnythingLLM 这个软件。去官网下载安装,安装好启动后,在模型选择位置选 ollama,就能看到我们下载的 DeepSeekR1 模型了。创建个工作区,随便取个名,我取名为 DeepSeek-iGPU,选中工作区再选 NewThread 开启新对话,就能和 DeepSeekR1 愉快聊天啦。我让它介绍 Ultra 系列处理器,它不仅回答得条理清晰,思考链也正常工作,而且模型的 token 生成速率大约为 10token/s,个人使用对话很流畅。从任务管理器能看到,核显基本满载,用了 7.2G 主机内存。

最后说说 NPU。Ultra 245K 的 NPU 是个大亮点,虽然我一开始想用它部署模型,但因为 NPU 太新,遇到了不少 bug。不过我已经把这些 Bug 提交到 Intel ipex-llm 了,按照他们的更新速度,下个月左右应该就能用 NPU 进行模型推理和部署,到时候核显压力会更小,还能构建更高性能的 AI 工作站。

这次用 Ultra245K 搭建 DeepSeek 本地模型,整体体验还是很不错的。虽然过程中遇到了一些小波折,但最后成功跑起来模型,还能流畅对话,成就感满满。如果大家也对本地化部署大模型感兴趣,不妨参考我的经验试试,有问题咱们评论区交流!