最近一直在用deepseek的r1模型写文案摸鱼,不得不说确实功能很强大。但是一直网络繁忙是个问题,于是自己找了一些教程本地化部署,这里介绍的是ollama。

第一步:下载ollama

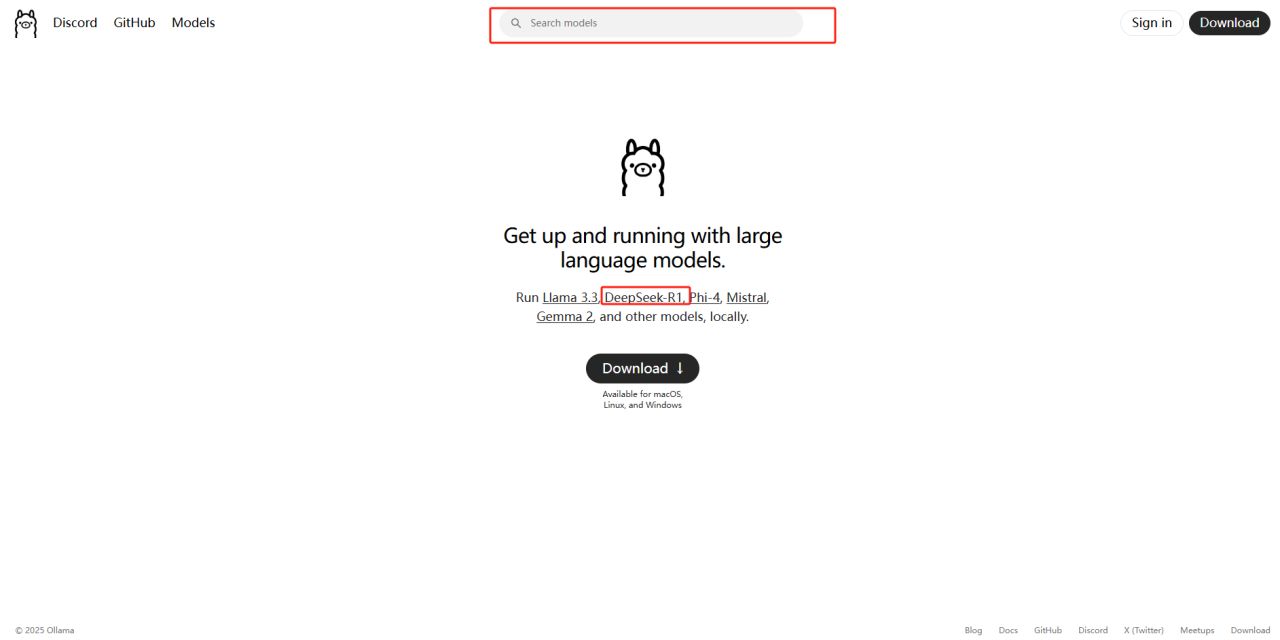

1.访问ollama官网

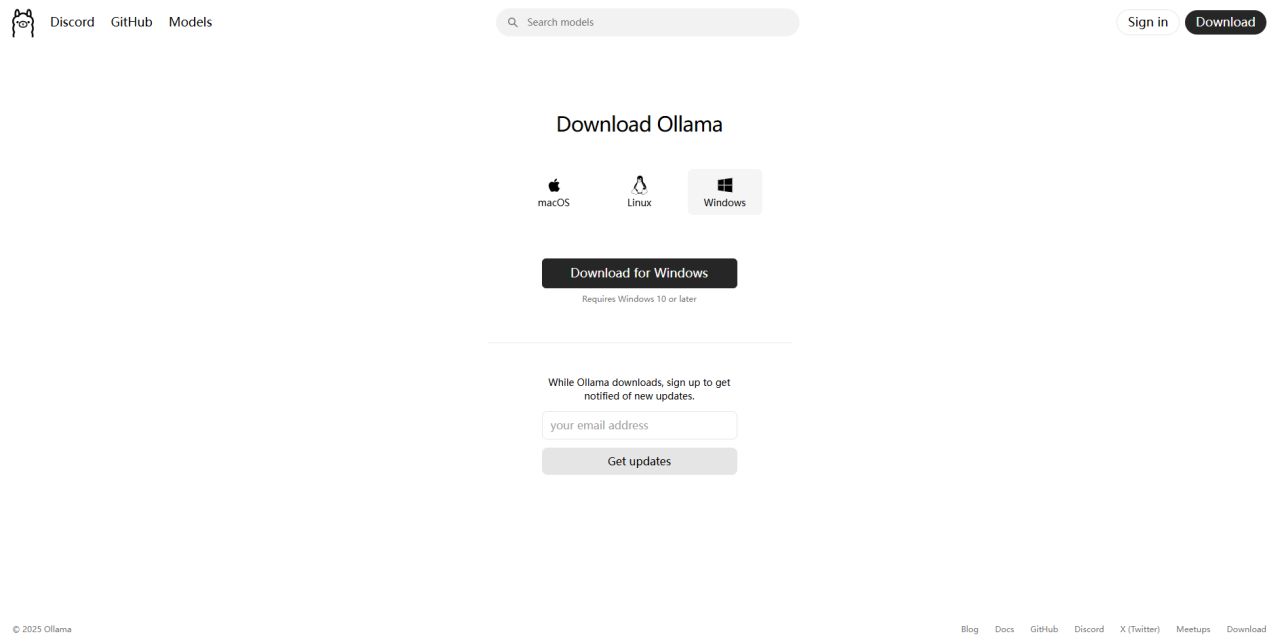

2.点击下载(Download)

3.选择你自己的操作系统下载,我这里以win系统为例。

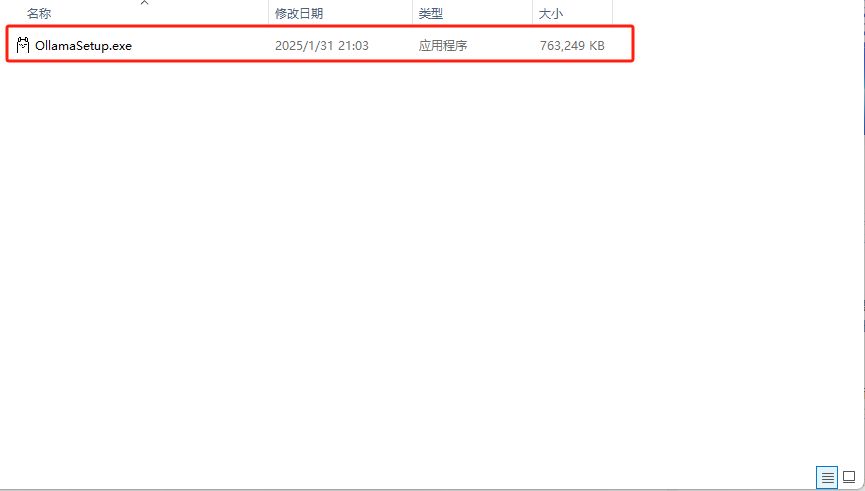

4.双击安装包,安装ollama,等待安装完成

第二步:安装deepseek R1大模型

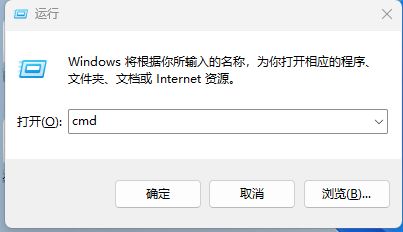

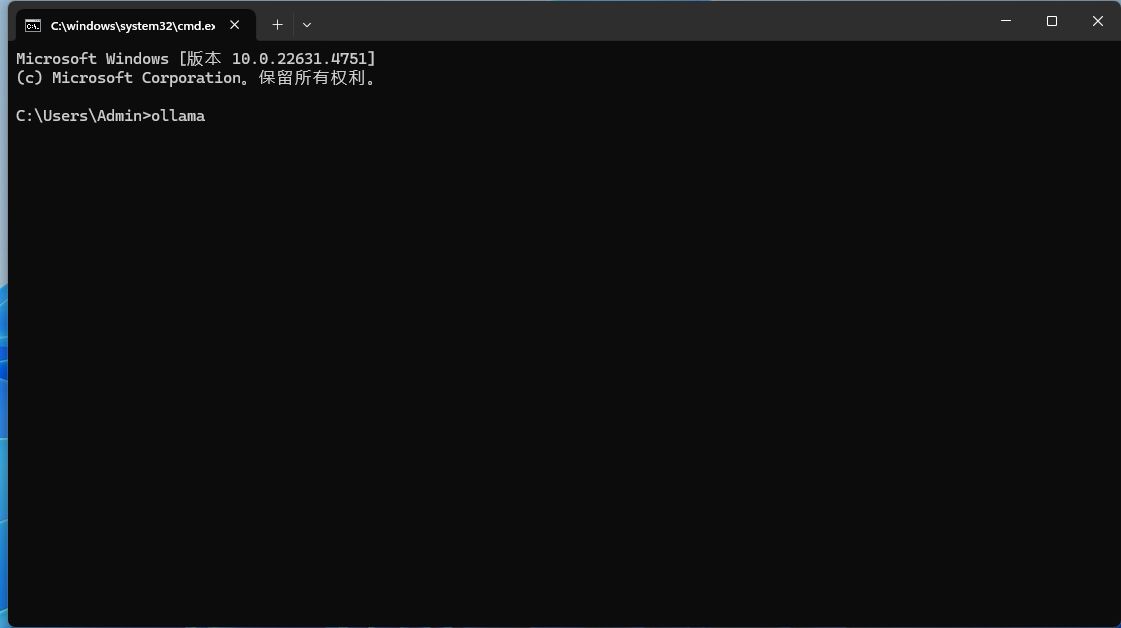

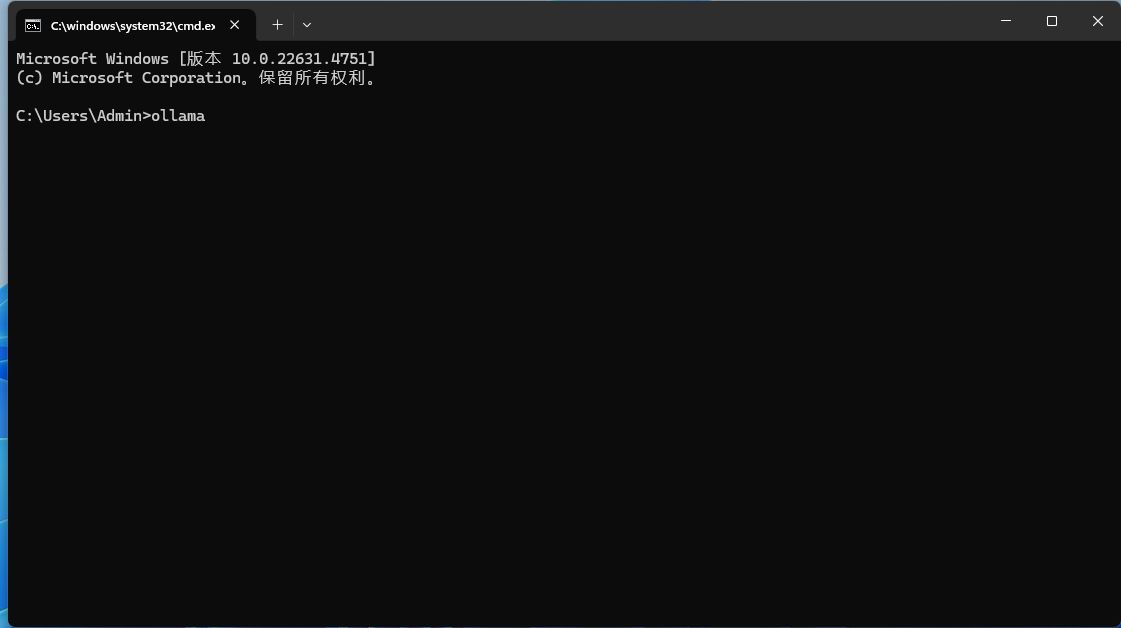

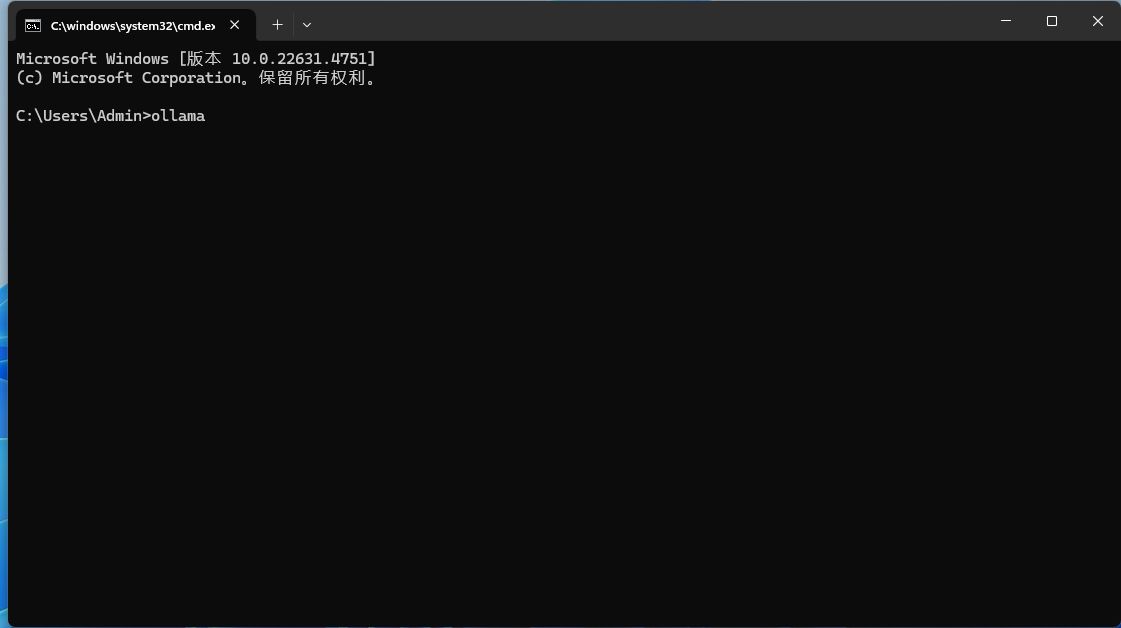

1.按win+R键,输入 cmd ,回车打开。

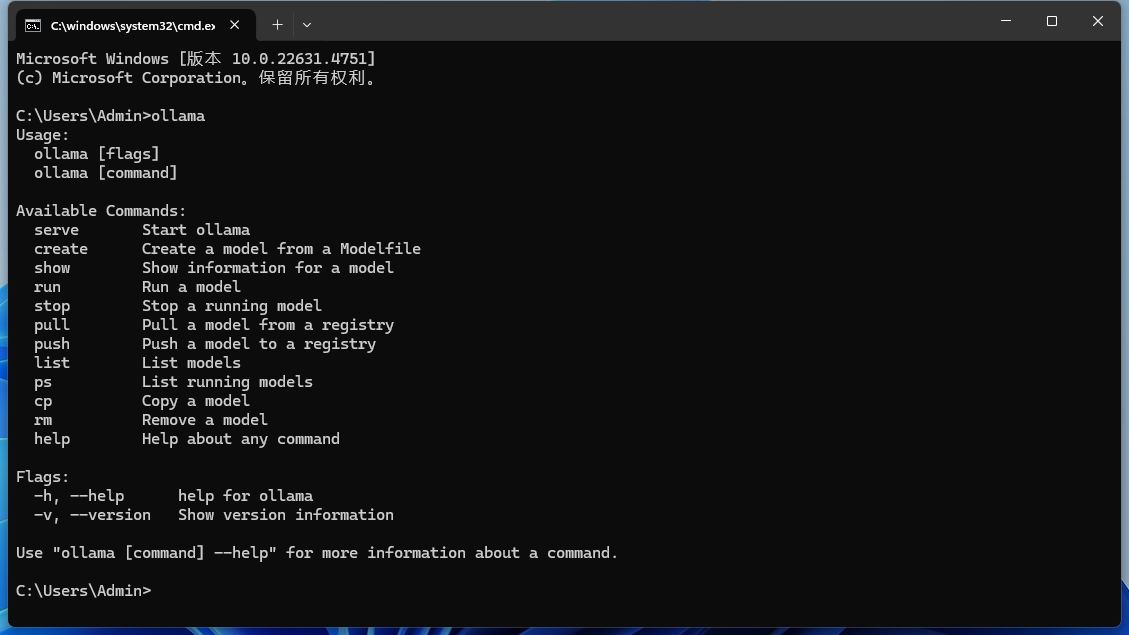

2.直接输入ollama,弹出以下界面即为安装成功。

3.访问ollama官网,选择对应模型。

可以直接点击deepseek或者搜索框搜索。

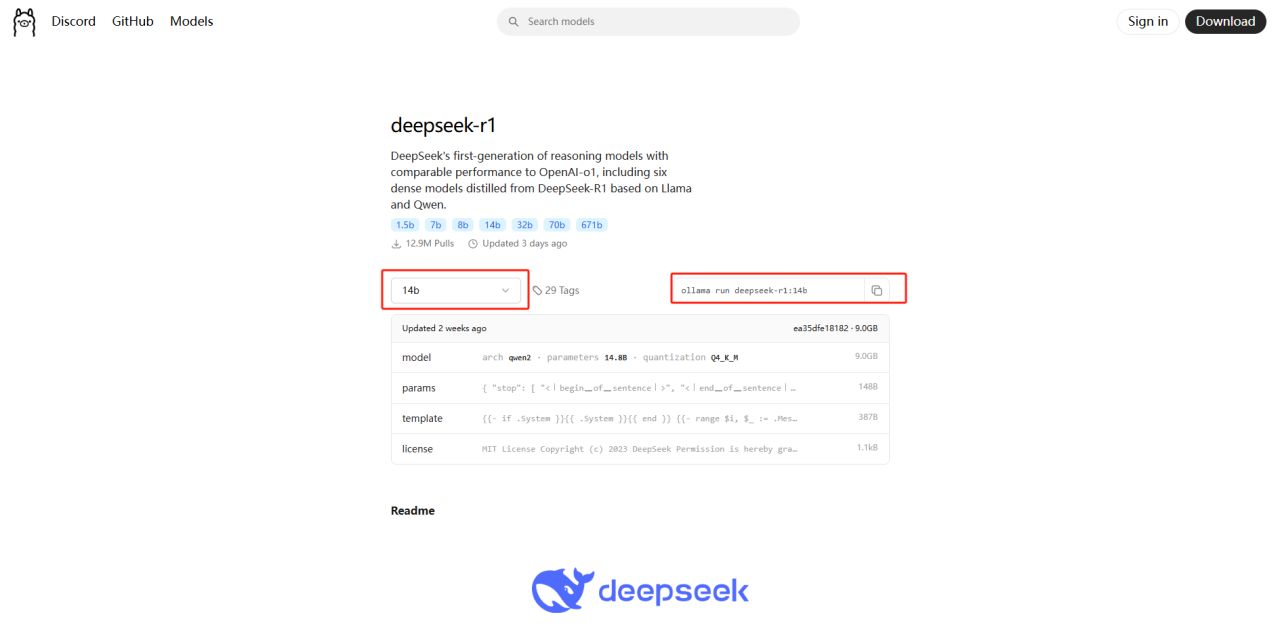

4.复制模型的下载码

左侧的 14b 意思是下载140亿参数的R1,这个根据自己的电脑配置来,实测公司的电脑,无显卡i3-12100,可流畅运行1.5b参数。家里的 4070ti super,7800x3d,可无压力运行14b参数,各位自营参考。

(参数越多,能力越强,官方部署的为671b的完整版本)

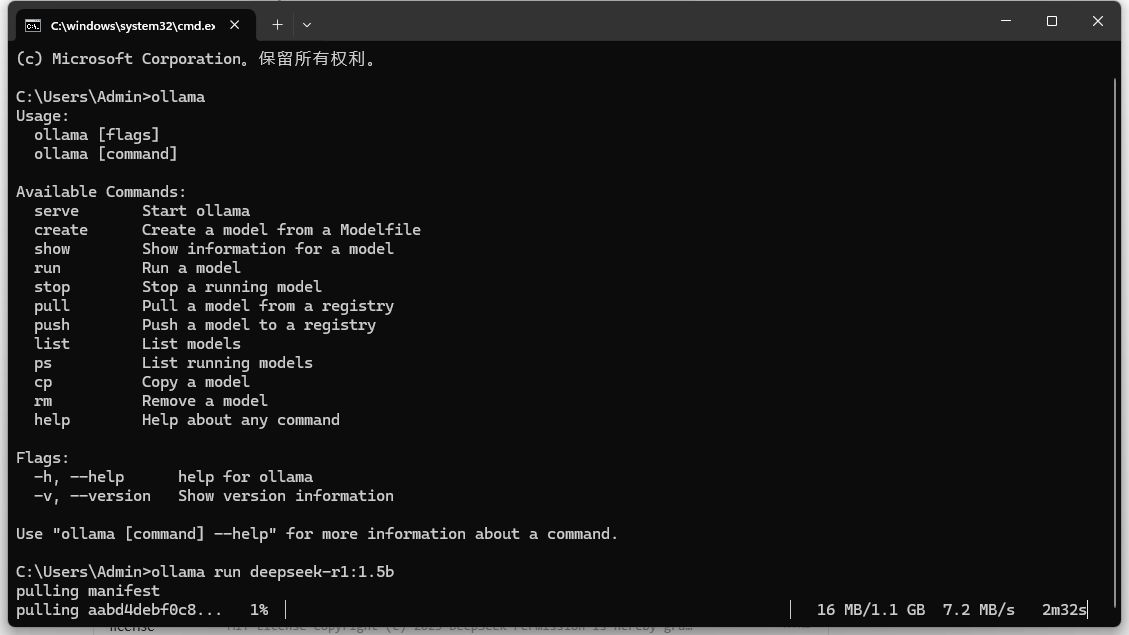

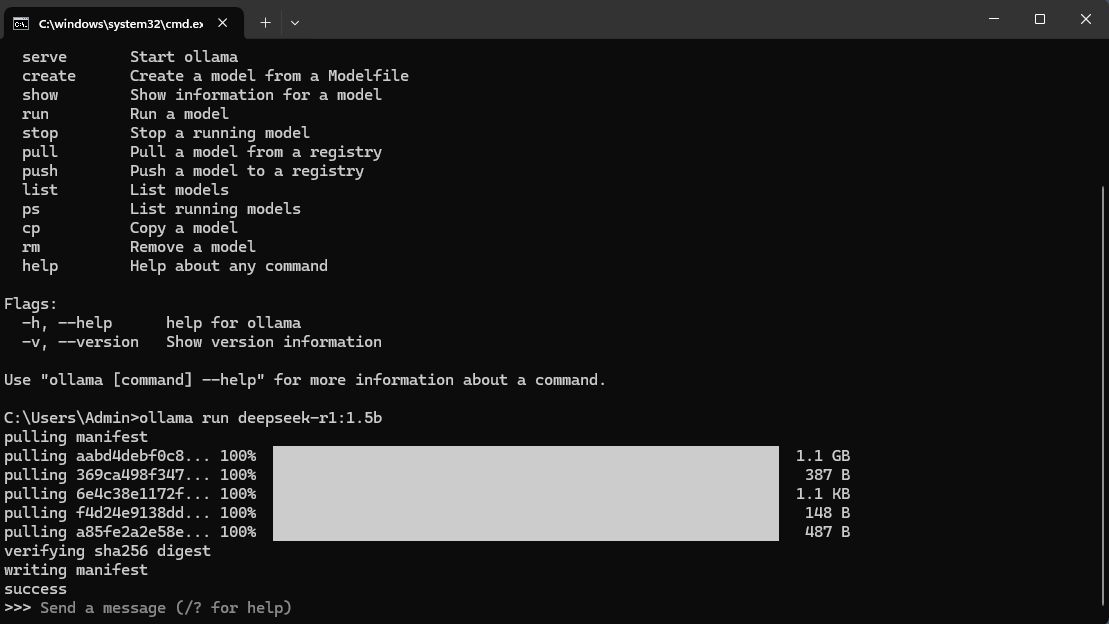

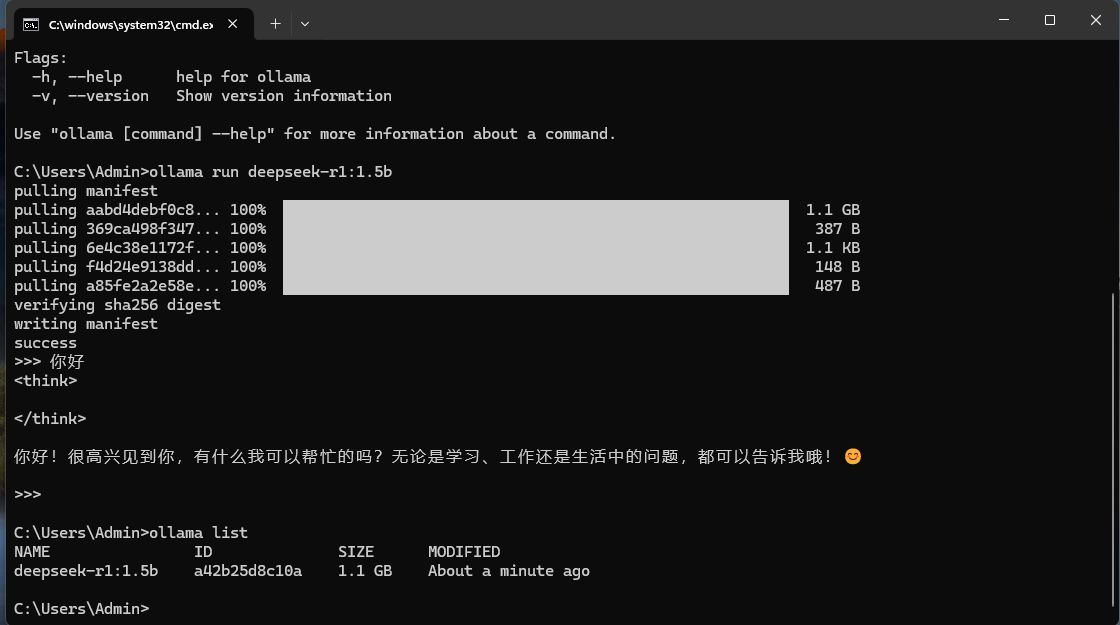

5.下载deepseek R1

在cmd界面输入ollama

接着粘贴你在ollama官网复制的下载码,我这里以1.5b为例。等待下载完成

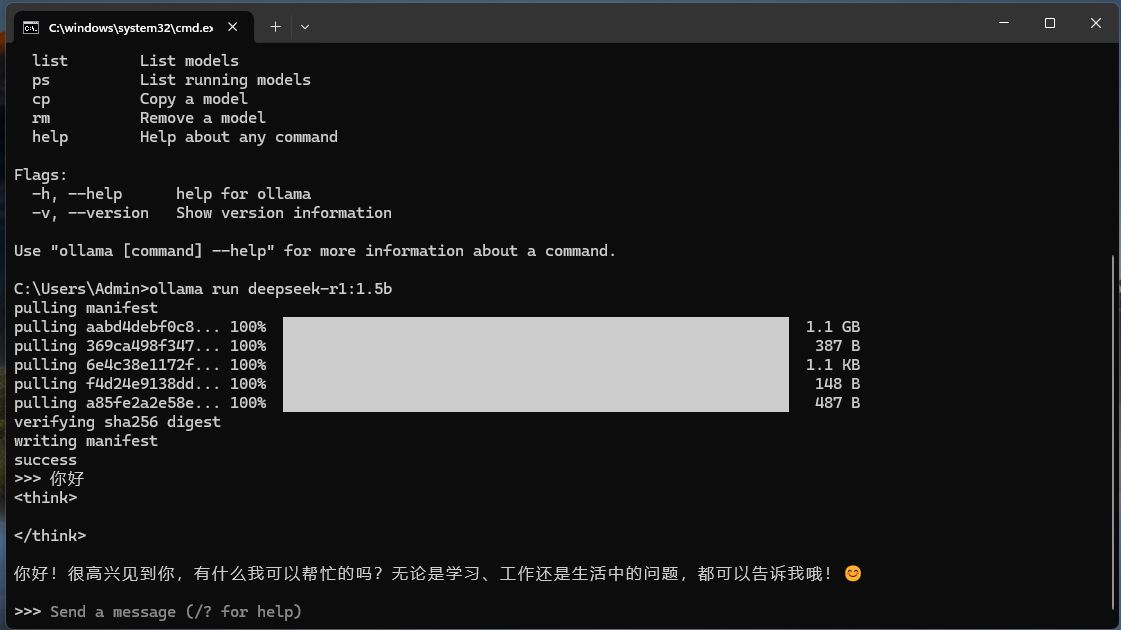

下载完成就可以使用了。

访问其他模型办法:

ollama还可下载其他模型,通过之前的办法复制下载码下载。在启动时选择自己想要的模型运营,具体方法如下。

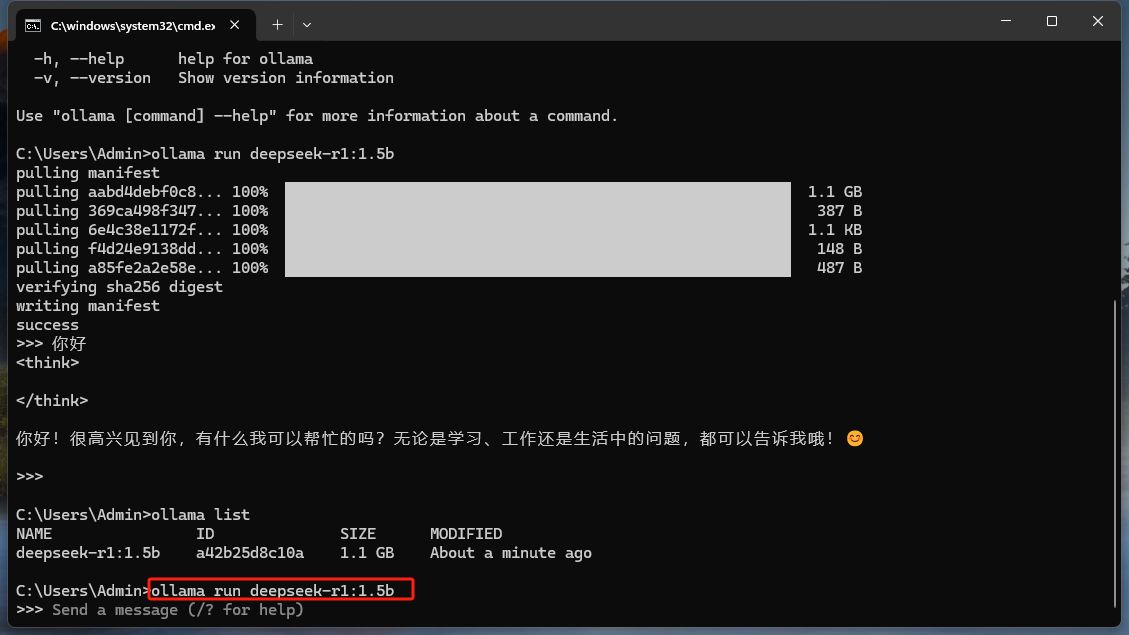

1.在cmd界面输入ollama

2.接着输入ollama list,可以看到你已经下载的所有模型。

3.接着输入 ollama run (直接复制清单中你已经下载的模型就行,我这里以1.5b的R1为例)

回车即可运行使用啦。

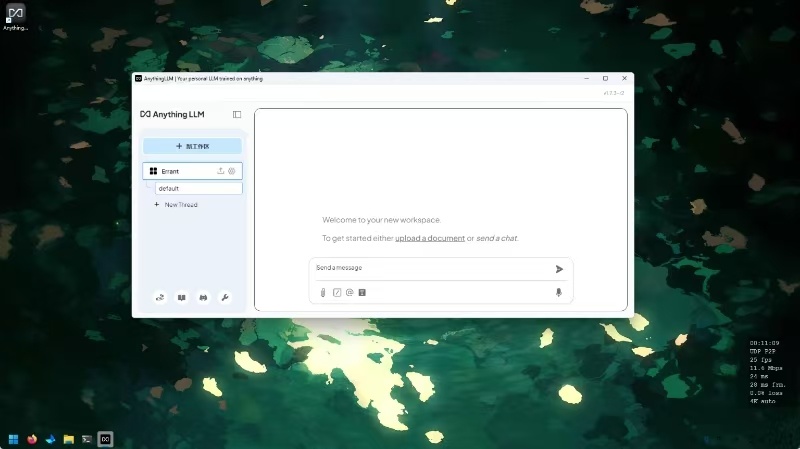

这个是最基础的使用方法,还有通过llm studios,anything llm等应用可视化访问,联网搜索,接入酒馆的方法,像这样。

后续看情况更新。