大語言模型的熱潮帶來了一波又一波的ai應用,彷彿一夜之間不會用大語言模型就已經落伍了。相較於一開始大語言模型對硬件的極致消耗,現在的大語言模型在推理階段已經不需要再消耗那麼高的顯存和性能了,部署平臺也從雲服務器逐漸走向了邊緣計算。而我們一般玩家現在已經擁有了可以用來跑語言模型的顯卡,卻囿於不熟悉深度學習平臺,導致有力無處使

上一次我比較詳細地做了一個AMD平臺顯卡的ROCm深度學習計算部署的教程,但是畢竟是在命令行下運行,涉及到很多軟件的安裝以及環境配置,對於一般玩家來說還是太麻煩了。所以這次,我就出一個簡單的完全不需要配置環境的大語言模型部署教程,來教大家怎麼利用性能過剩的顯卡(bushi)在本地部署大語言模型

簡介

首先來簡單介紹一下AMD的ai計算目前對大語言模型(以下簡稱LLM)的支持狀況,除開cDNA這種專門用來訓練LLM的計算卡,專業卡和一般的遊戲顯卡的6000系以及7000系,還有目前已經配備了NPU的8000 APU,都能支持ROCm加速。而Meta公司的Llama以及其他優化後的LLM,也支持了ROCm平臺

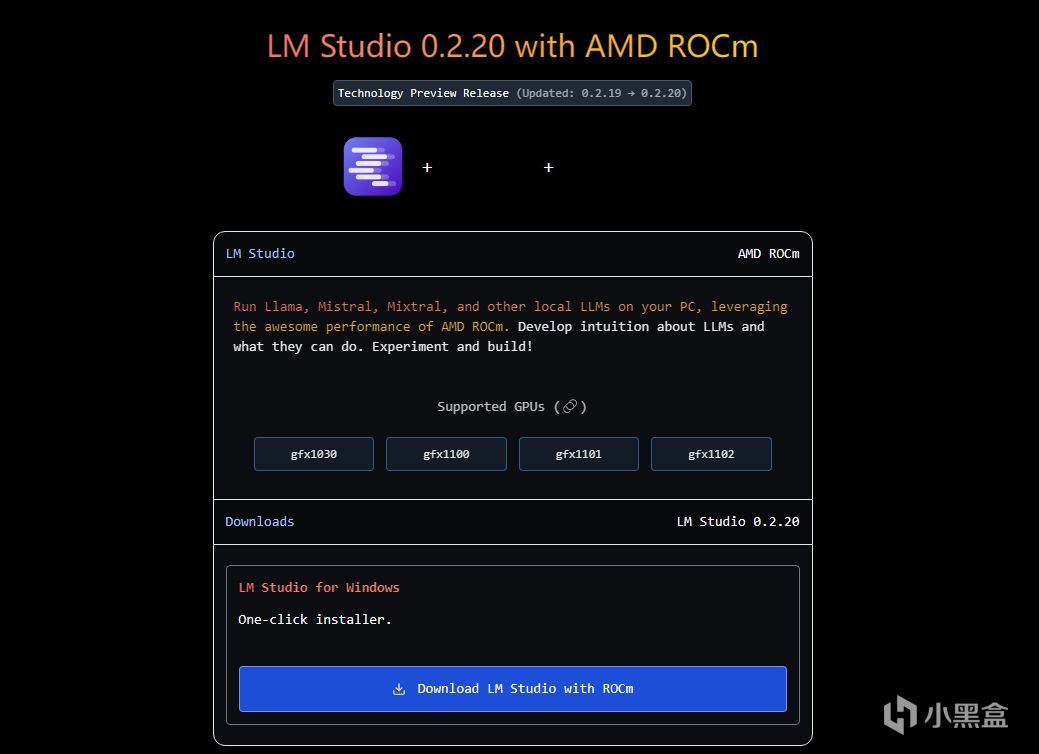

本次要用到的軟件,就是一個專門為LLM所設計的部署工具,名叫LM Studio,可以在這個鏈接進行下載:LMSTUDIO。這個軟件已經支持了ROCm加速,而且GUI做得非常好

使用的平臺為AMD的7900X+RX7900XT,內存為金士頓的Renegade 6400 48Gx2。這個配置也是上次用於ai繪畫的教程中的硬件配置,性能非常充裕,可以靈活地適配各種應用

部署Llama3 8B大語言模型+測試性能

下載好LM studio with ROCm之後就能直接打開,安裝過程我就不多說了,和一般軟件沒有區別。打開之後可以看到一個總覽頁面,裡面有各種來源和規模的LLM可供部署

然後我們搜索一下Llama,下載Llama3 8B,這時候大家就會發現下不動,因為這些模型開發者為了圖省事,是直接用的huggingface的來源。這個來源下載速度本身就很慢,很容易就會出現失敗。但是不用擔心,因為點開正在進行的下載任務,下載鏈接就在下方的下載詳情中,直接複製即可

下面放入瀏覽器裡面,直接回車就能用瀏覽器的下載器進行下載,因為瀏覽器的下載器一般只會進行原網頁的下載,所以這樣依舊很慢,如果不嫌慢的話一晚上應該能下好

所以我們叫出某不知名P2P下載器,某雷可以利用多個來源進行加速,直接從國內下好的地址轉過來,速度直接提升無數倍。下好的模型當然也是沒有辦法直接用的,需要放入指定的位置軟件才能讀取到

軟件邊欄裡面有一個文件夾圖標,打開這一項,上方有一個show in file explorer,點擊即可進入模型的文件夾

因為模型從屬於不同來源的不同分支,所以在這個文件夾下還需要單獨為Meta/Llama創建文件夾,然後把模型按照./Meta/Llama/下載好的模型放入,這樣軟件就能讀取到模型的信息了

然後我們打開邊欄的對話圖標,最上方的選項裡就能插入這個已經下好的模型,那麼話不多說,趕緊加載一下嚐嚐味道吧

對於一般的8000系APU和ZEN4的Ryzen CPU而言這樣基本就結束了,但是如果有一張規模比較大的顯卡的話,就要把右邊邊欄中的Hardware Setting的GPU Offload打開到max,這樣才能使用全部的GPU核心

打開之後需要重新加載一次模型讓模型從內存中轉移到顯存裡面,然後我們來問模型一些簡單問題,就能看到模型的性能消耗明顯從核顯+獨顯(第一個峰值)轉變為了純獨顯(第二個峰值)這樣的模式

為了讓大家直觀的感受到顯卡帶來的加速,我測試了各個檔位下的推理速度,從max到無dGPU

可以看到在8layer以及16layer下,GPU的加速並不算明顯,但是開到max之後,就能得到質的飛躍。而就算不開dGPU加速,Ryzen本身的推理能力就不差,而且也算是ROCm設備,同樣可以實現簡單的加速,有一個不錯的基礎速度

Llama經過重新訓練之後的8B模型確實非常快,一張顯卡生成速度直接起飛,比雲端上的API接口反應迅速很多,而且沒有明顯的道德和政治傾向。而且因為是獨立的本地模型,不會存在數據洩露的風險,所以就安全性而言比雲端的服務要好很多

本地API接口

如果有進階的應用需求,那就需要用到API接口,而LM Studio也有對應的功能,在邊欄中有一項就是打開本地接口。但是在運用上並不簡單,接口需要搭配前端使用,會玩的朋友可以自己試試,我就不單獨講解了,一般玩家也確實用不上這個

總結

大語言模型的革新浪潮不可避免,因為它的工具屬性實在是太強了,和一般的AI應用相比泛用性強太多,而且可塑性也非常不錯,現在我都已經見到不少大語言模型用作劇本殺和跑團bot 的情景了。而大語言模型也能給我們平時帶來不少便利,語言模型最強的功能就是Summarization,也就是從各種來源的信息中搜羅總結出凝練的結論,對於查資料和查方法來說非常好用

而本地部署的大語言模型在下載完成後就能完全離線使用,不用擔心數據洩露以及隱私暴露問題。而且下載好的語言模型不具有記憶性不具有學習行為,雖然沒什麼長進,但是也避免了越用越歪的情況,畢竟想要更新的模型隨時都可以從LM Studio裡找到,用歪了重下對本地使用還是會有影響的。AMD的ROCm在大語言模型推理上已經經過了優化,僅使用CPU就已經能有不錯的基礎性能,在GPU加速之後對話生成非常流暢,尤其是7900XT完全加速之後可以用暢爽來形容,所以大家趕緊利用好手裡的顯卡,也來試試大語言模型能不能給你帶來幫助吧

硬件介紹

下面是部署時用的硬件